Como vocês faziam para viver quando ainda existia realidade?

Se você acha que já é coisa do passado o fenômeno das fake news – notícias falsas criadas e circuladas viralmente para manipular a opinião em massa na internet –, vale lembrar que já existe uma nova geração deste problema, decorrente dos avanços da inteligência artificial: são as chamadas deepfakes.

LEIA TAMBÉM: Todas as colunas de Ronaldo Lemos

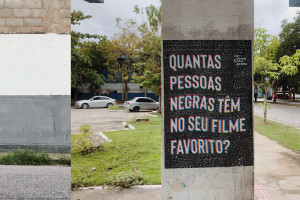

O termo faz referência à técnica do chamado “aprendizado profundo”, em que computadores passam a ser capazes de não apenas entender imagens e sons, mas também de sintetizá-los. Em outras palavras, essas máquinas conseguem gerar vídeos, fotos e áudios artificialmente. Inclua entre as possibilidades a capacidade de criar imagens falsas de políticos falando ou fazendo alguma coisa, inclusive em situações vexatórias, de autoridades policiais cometendo violência injustificada para atiçar revoltas, ou mesmo filmetes incendiários, com mensagens políticas ou sociais capazes de inflamar pessoas.

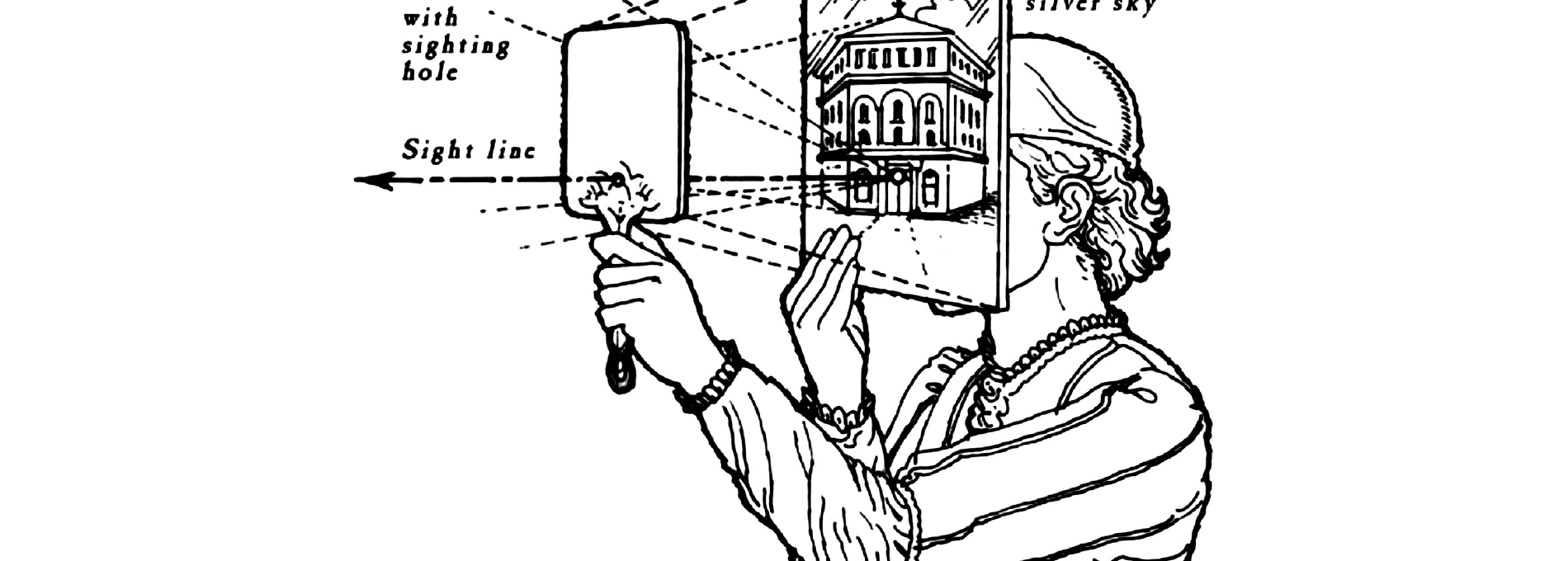

O problema é que nós, seres humanos, confiamos em fotos e vídeos. Quando “vemos com nossos próprios olhos”, há um verdadeiro “efeito São Tomé”, em que suspendemos a descrença e acreditamos que aquilo que se passa na tela é “verdadeiro”. Pois bem, no mundo em que vivemos hoje, não pode ser assim, não dá para confiar em mais nada.

Como faz?

Algumas aplicações recentes das deepfakes incluem colocar o rosto de celebridades com perfeição em imagens de filme pornô. Recentemente, circulou amplamente o vídeo em que o rosto e a voz do ex-presidente dos Estados Unidos, Barack Obama, eram sintetizados artificialmente, com ele falando qualquer coisa que o programador quisesse. Quem assistisse sem saber do que se tratava, provavelmente acreditaria que Obama estava realmente falando aquilo.

Há atualmente três propostas na mesa sobre como combater as deepfakes, todas insatisfatórias.

A primeira é usar a própria inteligência artificial para identificar imagens forjadas; o problema é que um dos principais métodos de desenvolvimento de fake news consiste justamente em treinar esses programas contra outros programas capazes de identificar seus erros. Ou seja, quanto mais sofisticada for a detecção automática, mais sofisticadas as deepfakes se tornarão. Vale um exemplo: uma falha comum hoje é que os rostos não piscam como um ser humano, com a regularidade necessária, mas isso será facilmente corrigido e, por isso, esse tipo de detecção não vai durar muito.

Outra possibilidade seria criar um “certificado de realidade” embutido nas câmeras e gravadores de áudio e vídeo. Toda imagem capturada diretamente da realidade seria registrada no blockchain e carimbada digitalmente, certificando-a como verdadeira, não alterada. A ideia vai gerar uma enorme burocracia, além de resistência dos fabricantes de equipamentos e mesmo das redes sociais. Além disso, é claro, vai ter muita gente fraudando o processo, criando certificados de realidade falsos.

Por fim, a proposta mais recente é o chamado authenticated alibi services (serviços de álibi autenticados). Nesse caso, a pessoa que não quiser ser vítima das deepfakes passa então a registrar todos os momentos da sua vida em detalhes: onde esteve, com quem esteve, por quanto tempo e assim por diante. Se alguém criar algum boato sobre ela, a pessoa poderá recorrer aos próprios relatórios para comprovar que é mentira. Pode parecer loucura, mas já tem pessoas públicas e políticos (honestos) considerando adotar essa possibilidade para evitar ataques.

Estamos vivendo em um mundo no qual a ideia de realidade fica cada vez mais ofuscada. No futuro, vai ter quem pergunte: “Como vocês faziam para viver quando ainda existia realidade?”.