A partir do seu histórico de navegação, ferramentas de inteligência artificial tentam identificar seu gênero – mas muitas vezes reforçam representações sexistas.

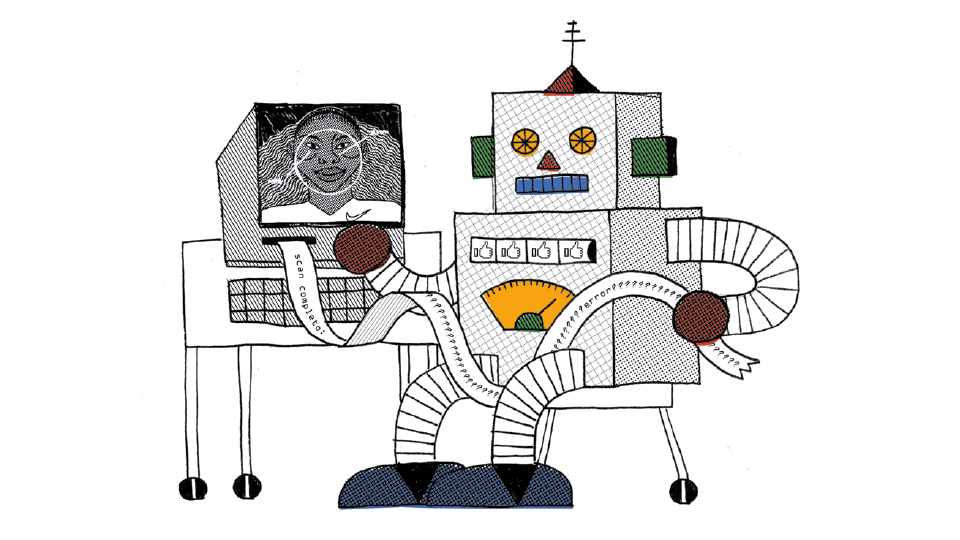

Eu sou um jovem adulto, interessado em surf, televisão e tecnologia. Meu companheiro é uma jovem que gosta de casa e jardim, culinária e política. Esta foi a leitura de uma ferramenta de marketing digital que pretende traçar o perfil do usuário em tempo real.

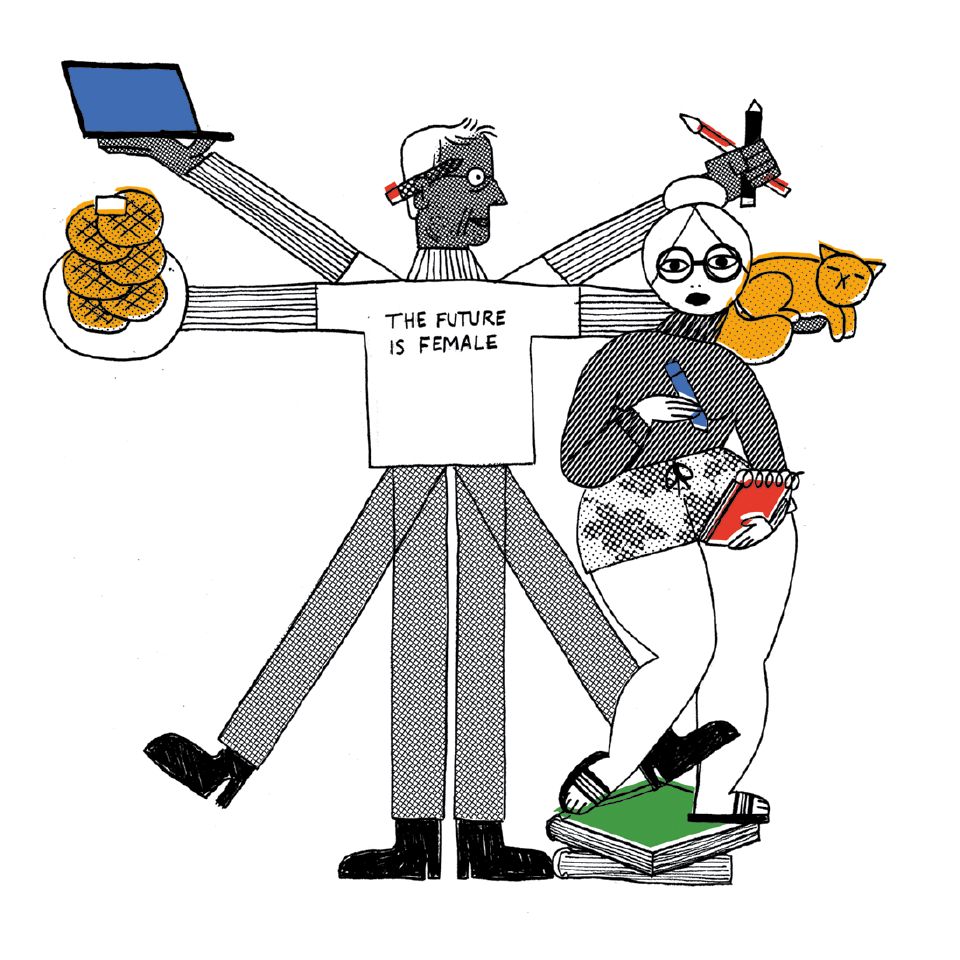

O detalhe é que eu sou uma jornalista freelancer, não tenho TV e, embora tenha morado no litoral catarinense, nunca surfei. Meu companheiro é um designer de 41 anos, mas, por compartilhar memes feministas, receita de waffle de couve-flor e vídeos de gatinhos (me marcando), talvez a internet o identifique como alguém do gênero “feminino”.

A partir de padrões de navegação (como cookies, dados geolocalizados e informações pessoais), ferramentas de inteligência artificial classificam o comportamento de milhões de usuários e tentam traçar uma identidade digital para nos definir como público-alvo para empresas. Mas os softwares reproduzem frequentemente estereótipos inventados pela mente humana – como os clássicos “menino veste azul e gosta de futebol” e “menina veste rosa e brinca de casinha”.

“Algoritmo parece algo muito tecnológico, mas são apenas regras que um ser humano criou”, definiu a cientista de dados Letícia Pozza na última edição da Casa Tpm. “O que devemos discutir é se as pessoas que criam essas regras são capazes de ensinar esses algoritmos a buscar diversidade. Imaginem que a gente precise criar um algoritmo para selecionar os melhores CEOs do mundo. Se fizermos esse estudo nos EUA, onde mais de 80% dos CEOs são homens brancos, dificilmente o algoritmo vai selecionar uma mulher ou um negro. Quando elaboramos regras baseadas no histórico que temos, o algoritmo perpetua esse histórico desigual.” Segundo estudo da Universidade de Washington, apenas 11% das fotografias do gigantesco acervo do Google relacionam a busca pela palavra-chave “CEO” a empresárias. Por outro lado, mulheres são maioria nas ilustrações de enfermeiras (86%) e atendentes de telemarketing (64%).

Para Paulo Planet, diretor de operações da Tail (empresa de análise de big data), a possibilidade de segmentação de audiência se tornou cada vez mais precisa com os avanços tecnológicos. “Desde que a publicidade é publicidade, uma marca traça um plano de mídia com foco em alguém, por exemplo mulheres de 25 [anos]+, [classes] A e B. Mas as campanhas atuais estão deixando esta lógica”, diz. “É mais importante compreender o comportamento. Uma tendência atual do mercado, acompanhando as discussões na sociedade, é caminhar para uma publicidade mais unissex – ou, para algumas marcas, abordar diretamente a discussão de identidade de gênero”, analisa.

LEIA TAMBÉM: Ronaldo Lemos fala sobre deepfakes, fake news e simulação de realidade

Lógica binária

“Embora rode a partir de um processo matemático, o algoritmo traz embutido juízo de valor, inclusive sobre o que é considerado ‘feminino’ e ‘masculino’”, diz Joana Varon, diretora-executiva da organização Coding Rights e uma das fundadoras do grupo ciberfeminista DeepLab. Desde 2015, ela investiga o uso de inteligência artificial com foco em questões de gênero na América Latina. O estudo Você Está Vendo Isso Porque É Uma... expôs como anúncios direcionados miram mulheres como público-alvo no Facebook, num nível impressionante de detalhamento.

No caso de uma mulher na faixa dos 30 anos, ainda que ela preserve suas informações pessoais (como idade, status de relacionamento ou o que pensa sobre maternidade, família e filhos), os algoritmos “entendem” que é hora dela pensar sobre congelamento de óvulos, por exemplo. Sem esquecer que, se a informação de gênero for ocultada, é possível que campanhas ligadas à fertilidade sejam entregues a homens, mas não por considerarem que o tema é de interesse comum, mas porque os estereótipos de navegação foram identificados como femininos. “A lógica é binária: feminino e masculino. Ao destrinchar o funcionamento do algoritmo, notamos que não há muita diferença em relação às publicidades do passado”, critica Joana.

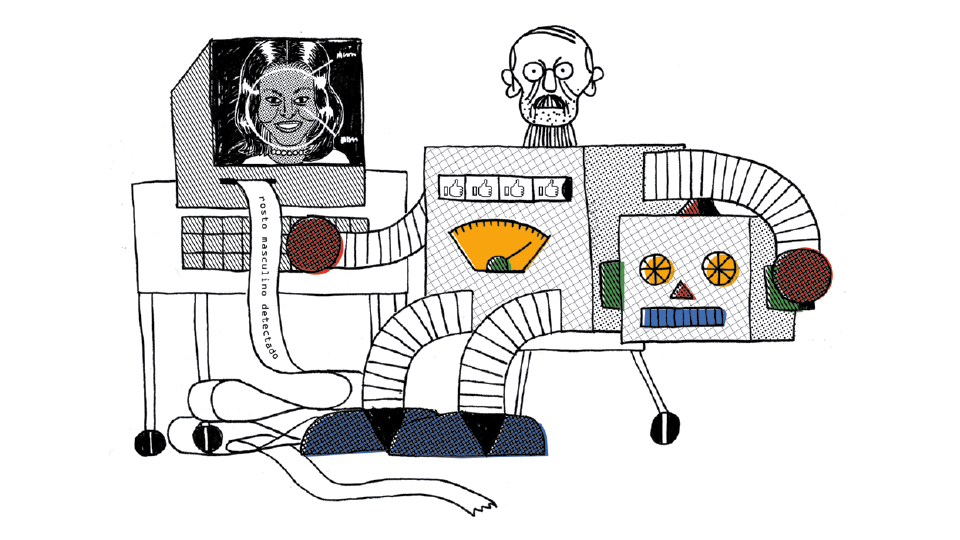

Um estudo recente, realizado na Universidade de Virgínia, revelou que os algoritmos também leem imagens de modo sexista: ao analisar dois acervos de mais de 100 mil fotografias e suas legendas, o programa interpretou imagens de indivíduos na cozinha e as associou imediatamente a mulheres – mesmo quando quem está diante de um fogão na foto é um homem. Já na Universidade de Boston, outra investigação constatou que o mecanismo de busca do Google News também tinha bugs machistas: ao digitar a frase “um homem está para um programador de computação como uma mulher está para uma...”, o software respondia “dona de casa”.

“Desigualdade social, heranças históricas e até diferenças culturais e geográficas podem causar desafios de representatividade. Algoritmos são um reflexo do comportamento humano e certos vieses podem ser influentes no comportamento do sistema”, escreveu a cientista de dados Carolina Bigonha, cofundadora da Hekima (empresa que desenvolve soluções de inteligência artificial), na revista do Núcleo de Informação e Coordenação do Ponto BR (NIC.br).

LEIA TAMBÉM: Mulheres hackers e o ciberfeminismo devem transformar a internet como conhecemos hoje

Aprendendo, sempre

Algoritmos podem refletir visões de mundo de seus desenvolvedores, além de construir padrões a partir dos dados disponíveis – uma matriz ininterruptamente abastecida por informações pessoais, dados de governos e organizações, transações financeiras, histórico, check-ins e até sensores de sons, movimentos e luzes. Mas, assim como nós, eles podem aprender a ler o mundo com lentes melhores.

Segundo Carolina, desenvolvedores devem estar sempre alertas para prevenir e corrigir erros e resultados enviesados, aprimorando códigos para o chamado “aprendizado de máquina”. “Os criadores de sistemas de inteligência artificial devem atuar como ‘detetives’, a fim de entender melhor o modelo [do aprendizado de máquina] e as bases de dados, e acompanhar os resultados. Há uma série de cuidados que precisam ser tomados para que a inteligência artificial seja segura, justa e inclusiva”, diz à Tpm.

Para “treinar” as máquinas, é importante adicionar dados inclusivos e representativos na fórmula, o que demanda o engajamento de líderes da indústria de tecnologia, especialistas, pesquisadores, governos e grupos da sociedade civil. Mobilizar esses ambientes e combater o viés algorítmico é a causa da Liga da Justiça Algorítmica (AJL), fundada pela cientista ganense— americana Joy Buolamwini.

Taxas de erro

Em junho, Joy divulgou o vídeo-manifesto AI, Ain’t I a Woman? (Inteligência Artificial, eu não sou uma mulher?, em tradução livre), que destacava parte de suas descobertas no doutorado no MIT Media Lab. Ela investigou a identificação de gênero e cor a partir de sistemas de gigantes da tecnologia (Amazon, Face++, Google, IBM e Microsoft). As taxas de erro foram muito altas para identificar imagens de mulheres negras (35%); já para homens brancos foi mínima (1%). Nem feições de mulheres negras icônicas como Michelle Obama, Oprah e Serena Williams foram reconhecidas como rostos humanos. Outro erro grave de sistema aconteceu em 2015, quando dispositivos de reconhecimento facial do Flickr e do Google marcaram homens negros como “gorilas” e “chimpanzés”.

“Se você digitar 'Brazilian woman' no Google, por exemplo, o retorno vai ser um monte de mulher dançando samba”, acrescenta a ativista e programadora Yasodara Córdova, pesquisadora brasileira no centro de estudos de ciberespaços de Harvard. Segundo Yaso, é importante exigir transparência e informação sobre o funcionamento das ferramentas. “Não sei se as empresas estão ‘tomando consciência’ ou se só estão com medo de processos judiciais ou escândalos na imprensa. Estamos só no começo dessas discussões, mas as pressões existem”, pondera.

LEIA TAMBÉM: Serviços como o Uber refletem a realidade da avaliação por redes sociais

Ativistas, cientistas e certas empresas estão empenhados em expor discriminações algorítmicas e buscar melhorias. Recentemente, a IBM lançou novos serviços de software e ferramentas para identificar e mitigar vieses na plataforma Watson – é como se um novo robô auditasse as classificações automáticas de outro robô, flagrando e corrigindo erros. Para a cientista de dados Ana Paula Appel, do Laboratório de Pesquisas da IBM Brasil, as empresas estão se conscientizando. “Algoritmos são como crianças: vão aprender dependendo do conteúdo que você mostrar. Se você apresentar um conjunto de dados que só tem homens e brancos, vai entender que essa é a realidade”, diz Ana.

Além de influenciar decisões no mercado publicitário, ferramentas de inteligência artificial também estão fuçando nossos dados para nos perfilar para marketing político (lembre do escândalo da empresa de dados Cambridge Analytica na campanha de Donald Trump à Casa Branca) e políticas públicas (tribunais americanos estão usando programas de computador para analisar o perfil de seus réus, influenciando até sentenças judiciais), o que vem provocando inquietações no mundo inteiro. Em dezembro, o Brasil aprovou a medida provisória para criar a Autoridade Nacional de Proteção de Dados (ANPD), que vai fixar regras e fiscalizar a coleta e o uso das nossas informações na internet.

E foi muito provavelmente por conta de uma “observação” dos algoritmos a respeito dos meus dados de navegação que recebi no dia 19 de fevereiro uma mensagem do Facebook Business na minha caixa de e-mail. O comunicado falava justamente a respeito deste tema. “As políticas de publicidade do Facebook proíbem que os anunciantes usem nossos produtos de anúncios para discriminar indivíduos ou grupos de pessoas. Os anúncios são discriminatórios quando negam oportunidades para indivíduos ou grupos de pessoas com base em determinados atributos, como raça, etnia, nacionalidade, religião, idade, gênero, orientação sexual [...].”

Embora correto, o texto não reflete necessariamente o que o próprio Facebook oferece a seus clientes na hora de distribuir anúncios, e tampouco costuma ter efeito no que é propagado na rede ou percebido dentro das grandes empresas de tecnologia.

Em outubro passado, descobriu-se que a americana Amazon, por exemplo, utilizava uma ferramenta de recrutamento de inteligência artificial que discriminava candidatos por gênero. Ou seja, a presença de palavras flexionadas no feminino (“capitã”, por exemplo) fazia o algoritmo jogar o currículo para o fim da fila, reforçando o histórico de predomínio masculino na indústria da tecnologia. Mas, ironicamente, a “mãe” de todos os algoritmos é uma mulher: a inglesa Ada Lovelace (1815-1852), autora do primeiro código complexo de programação do mundo.

LEIA TAMBÉM: Ronaldo Lemos reflete sobre o impacto do uso das redes sociais por governos e na construção de identidade

Daí a importância de aprimorar os algoritmos de modo que, ao invés de reforçar estereótipos, eles nos ajudem a combatê-los. Esta ação passa pelo debate dos temas, mas principalmente pela presença da diversidade nas empresas de tecnologia, para que o conteúdo e os serviços que são entregues por elas, além de refletir um mundo com mais equidade, tenham impacto na sociedade. “Isto começa com as pessoas. Por isso, é importante quem codifica. Estamos criando equipes completas com diversos indivíduos que podem verificar os pontos cegos uns dos outros? No lado técnico, é importante a forma como codificamos”, diz a cientista Joy Buolamwini em sua apresentação no TED, intitulada Como eu luto contra o preconceito em algoritmos.

Yaso corrobora a ideia: “Mulheres e pessoas não binárias (trans, por exemplo) conseguem identificar esses problemas na origem, antes mesmo dos testes, porque geralmente o design e a arquitetura desses sistemas envolve uma série de conceitos que são pessoais. Se há mais diversidade em tech, os produtos são mais inclusivos, dificilmente apresentarão visões que não são compatíveis com a visão de quem realmente faz as plataformas”.

Hora de passar a limpo a matemática da rede e humanizar o viés social dos algoritmos.

Créditos

Imagem principal: Vitória Bas

Vitória Bas